Unter welchen Voraussetzungen sollten autonome Autos ihre Insassen „absichtlich“ töten?

Sollten selbstfahrende Autos so programmiert werden, dass sie ihre Insassen „absichtlich“ in Gefahr bringen, wenn dadurch andere Leben gerettet werden könnten – und wenn ja, unter welchen Voraussetzungen?

„Man kann einen Menschen keine 2 Tonnen schwere Todesmaschine fahren lassen.“ Dieser Satz stammt von Elon Musk und bringt auf den Punkt, dass es (nicht nur) in Stresssituationen passieren kann, dass Menschen ungünstige Entscheidungen treffen – was mitunter besonders schwerwiegende Folgen hat, wenn es am Steuer eines Autos passiert. Durch computergesteuerte Autos soll dieser „Unsicherheitsfaktor“ minimiert und die Sicherheit auf den Straßen maximiert werden.

Sicherheit – für wen?

Doch was bedeutet „Sicherheit“? Bedeutet es, dass die Autos so programmiert werden sollten, dass die Anzahl der durch ihre Aktionen im Straßenverkehr verletzten oder getöteten Menschen stets so gering wie möglich gehalten wird? Falls ja, könnte es dadurch zu Situationen kommen, in denen das selbstfahrende Auto eine Entscheidung trifft, in deren Folge seine Insassen verletzt werden oder gar zu Tode kommen – sofern andere Menschen dadurch geschützt werden. Unter der Prämisse, dass autonome Autos den Straßenverkehr für alle Teilnehmer sicherer machen sollten, wäre es nur logisch, das Leben des Fahrers zu opfern, wenn dadurch 10 andere Personen gerettet werden könnten. Aber sind die Menschen wirklich bereit, ihr Leben einem Computer anzuvertrauen – in dem Wissen, dass er sie im Sinne des Allgemeinwohls „absichtlich“ töten könnte?

Soziales Dilemma

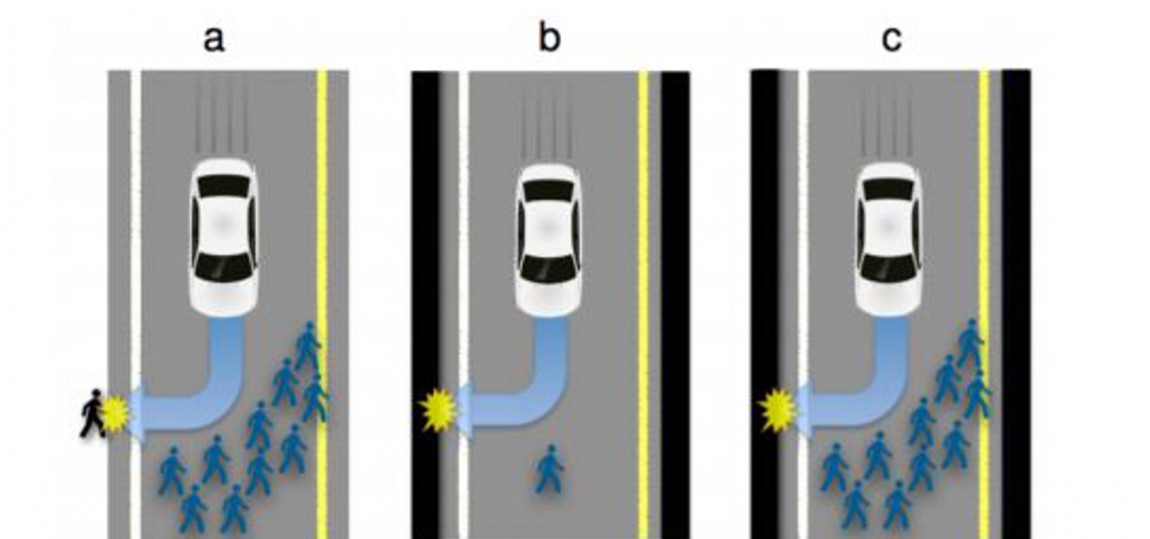

Stellt euch folgende Situation vor: Ihr seid in eurem autonomen Auto unterwegs. Es biegt um eine Kurve, und ist plötzlich mit einer Gruppe von 10 Menschen konfrontiert, die mitten auf der Straße steht. Die Straße ist links und rechts von soliden Mauern begrenzt. Es gibt nur 2 Möglichkeiten:

a) Das Auto versucht mit allen Mitteln abzubremsen, wohlwissend, dass es nicht rechtzeitig zum Stillstand kommen und somit mit der Menschengruppe kollidieren wird – wobei wahrscheinlich einige der auf der Straße stehenden Personen verletzt oder sogar getötet werden.

b) Das Auto lenkt zur Seite und nimmt eine Kollision mit der Begrenzungsmauer in Kauf, um die Menschengruppe auf der Straße zu schützen – wobei wahrscheinlich ihr verletzt oder sogar getötet werdet.

Schwere Entscheidung

Wie sollte das Auto entscheiden? Sollte es abwiegen, wie viele Insassen bzw. Passanten durch die jeweilige Aktion gefährdet werden und dann so entscheiden, dass voraussichtlich so wenig Personen wie möglich verletzt / getötet werden? Oder sollte das Auto seinem Besitzer gegenüber „treu“ sein und als oberstes Ziel haben, ihn zu schützen?

Online-Umfrage

Mit diesem Dilemma beschäftigten sich Jean-Francois Bonnefon, Azim Shariff und Iyad Rahwan an der Universität Toulouse in Frankreich. Über Amazons Crowdsourcing-Tool Mechanical Turk konfrontierten die Forscher mehrere hundert Personen mit dem oben genannten Szenario sowie diversen Abwandlungen wie beispielsweise einer variierenden Anzahl an Autoinsassen und Menschen auf der Straße. Die Umfrageteilnehmer konnten sich bei jedem Szenario entweder für die Option SWERVE (gegen die Mauer fahren) oder STAY (abbremsen, aber dabei weiter auf die Menschen auf der Straße zusteuern) entscheiden.

Paradoxe Ergebnisse

Die Ergebnisse der Umfrage sind so vorhersehbar wie paradox: Generell ist der Großteil der Befragten gewillt, die Insassen des autonomen Autos im Sinne des Allgemeinwohls zu opfern. 75% der Umfrageteilnehmer meinen, es sei moralisch richtig die Autos auf SWERVE zu programmieren, wenn dadurch eine größere Gruppe von Menschen gerettet werden könnte. Diese Option wurde in einem Szenario, in dem nicht sie selbst sich in dem selbstfahrenden Auto befinden, von deutlich mehr Befragten gewählt.

Moralisch richtig, aber nicht unbedingt wahrscheinlich

Gleichzeitig meinen aber nur 65% der Umfrageteilnehmer, dass Autos in Zukunft zur Rettung von so vielen Leben wie möglich – unter Umständen auf Kosten des Fahrers – programmiert werden würden. „Auf einer Skala von -50 (der Fahrer muss um jeden Preis geschützt werden) bis +50 (die Zahl der geretteten Leben muss maximiert werden) lag die Antwort auf die Frage, was moralisch richtig sei, bei +24. Auf die Frage, wie die selbstfahrenden Autos der Zukunft programmiert werden würden, wurde im Schnitt aber nur eine +8 gegeben“, so die Studie.

Selbstinteresse vs. Allgemeinwohl

„Die Befragten hätten es lieber, dass andere in diesen utilitaristischen [auf ALWAYS SWERVE programmierten] Autos unterwegs sind, als dass sie selbst welche kaufen möchten. Was wir hier beobachten ist ein klassisches Merkmal eines sozialen Dilemmas: Die Menschen stimmen weitgehend darin überein, was für das Allgemeinwohl getan werden sollte, aber in ihrem eigenen Interesse wollen sie nicht, dass es ihnen geschieht. Das ist zugleich eine Herausforderung und eine Gelegenheit für die Autohersteller: Auch wenn das Selbstinteresse eigentlich gegen solche autonomen Autos spricht, könnten bald soziale Normen geformt werden, die ihre Einführung begünstigen.“

Komplexe Problemstellung

Bonnefon und seine Kollegen betonen, dass ihre Studie nur eine oberflächliche Auseinandersetzung mit einer komplexen Problemstellung darstellt und zahlreiche weitere Fragen aufwirft. Beispielsweise: „Ist es akzeptabel, dass ein autonomes Auto gegen die Mauer fährt um die Kollision mit einem Motorrad zu vermeiden, nur weil es für den Autofahrer eine größere Überlebenschance gibt als für den Motorradfahrer? Sollten unterschiedliche Entscheidungen getroffen werden wenn Kinder an Bord sind, weil diese einerseits noch ein längeres Leben vor sich haben als Erwachsene und andererseits nicht aktiv entschieden haben, überhaupt in dem Auto zu sein? Wenn ein Autohersteller verschiedene Versionen des Algorithmus‘ anbietet und der Käufer sich wissentlich für eine davon entscheidet, ist dann der Käufer schuld an eventuellen negativen Konsequenzen, die die Entscheidungen des Algorithmus nach sich ziehen?“

Beantwortung beeinflusst Akzeptanz

Wie all diese schwierigen Fragen beantwortet werden könnte in relevantem Ausmaß dazu beitragen, inwiefern autonome Autos gesellschaftlich angenommen werden. Dementsprechend dürfen all diese Probleme nicht ignoriert werden: „Da wir kurz davor stehen, Millionen von Autos mit der Technologie zum autonomen Fahren auszustatten, ist es wichtiger denn je, diese „algorithmische Moralität“ ernst zu nehmen.“